Neben Begriffen wie 4K oder Full-HD, kennen inzwischen viele die Bezeichnung HDR. Sie steht auf jedem modernen Fernseher und Gaming-Monitor. Doch HDR ist nicht gleich HDR und es gibt zig Varianten davon. Wir erklären euch, was sie bedeuten und warum sie für euch wichtig sind.

Alle aktuellen Betriebssysteme, Spielekonsolen und selbst Blu-Rays und Spiele werben mit HDR-Unterstützung. Doch sobald man ins Detail geht, wird es kompliziert: HDR400, HDR10+, G-SYNC HDR und zig weitere Unterformate befinden sich auf dem Markt. Bevor wir uns aber die Unterschiede ansehen, klären wir erstmal was HDR eigentlich bedeutet.

Hier ein kurzes Beispiel-Video von LG zum Thema HDR und 8K:

DATENSCHUTZHINWEIS: Dieses Video ist im erweiterten Datenschutzmodus von YouTube eingebunden. Durch den Klick auf das Wiedergabesymbol willige ich darin ein, dass eine Verbindung zu Google hergestellt wird und personenbezogene Daten an Google übertragen werden, die dieser Anbieter zur Analyse des Nutzerverhaltens oder zu Marketing-Zwecken nutzt. Weitere Infos hier.

Was macht HDR?

Das Kürzel HDR steht für „High Dynamic Range“ und beschreibt drei Komponenten einer Bilddarstellung: Helligkeit, Kontrastverhältnis und Farbgenauigkeit. Klassische Medien ohne HDR-Unterstützung werden als SDR bzw. „Standard Dynamic Range“ bezeichnet. Kurz zusammengefasst, sorgt HDR für lebhaftere Farben, mehr Farbschattierungen und mehr sichtbare Details in dunklen bzw. hellen Bereichen.

Anhand der HDR-Funktion aktueller Smartphones und Kameras ist das gut zu erklären: Eine Kamera schießt hintereinander mehrere Bilder mit verschiedenen Belichtungen. Meist sind das drei Bilder mit einer niedrigen, mittleren und hohen Belichtung.

Diese verschiedenen Belichtungen werden dann zu einem Bild mit hohen dynamischen Umfang zusammengefügt. Auf dem neuen Bild sind helle Bereiche nicht ausgebrannt (z.B. Lampen, der Himmel oder die Sonne) und dunkle Bereiche zeigen mehr Details und sind nicht nur große schwarze Flecken.

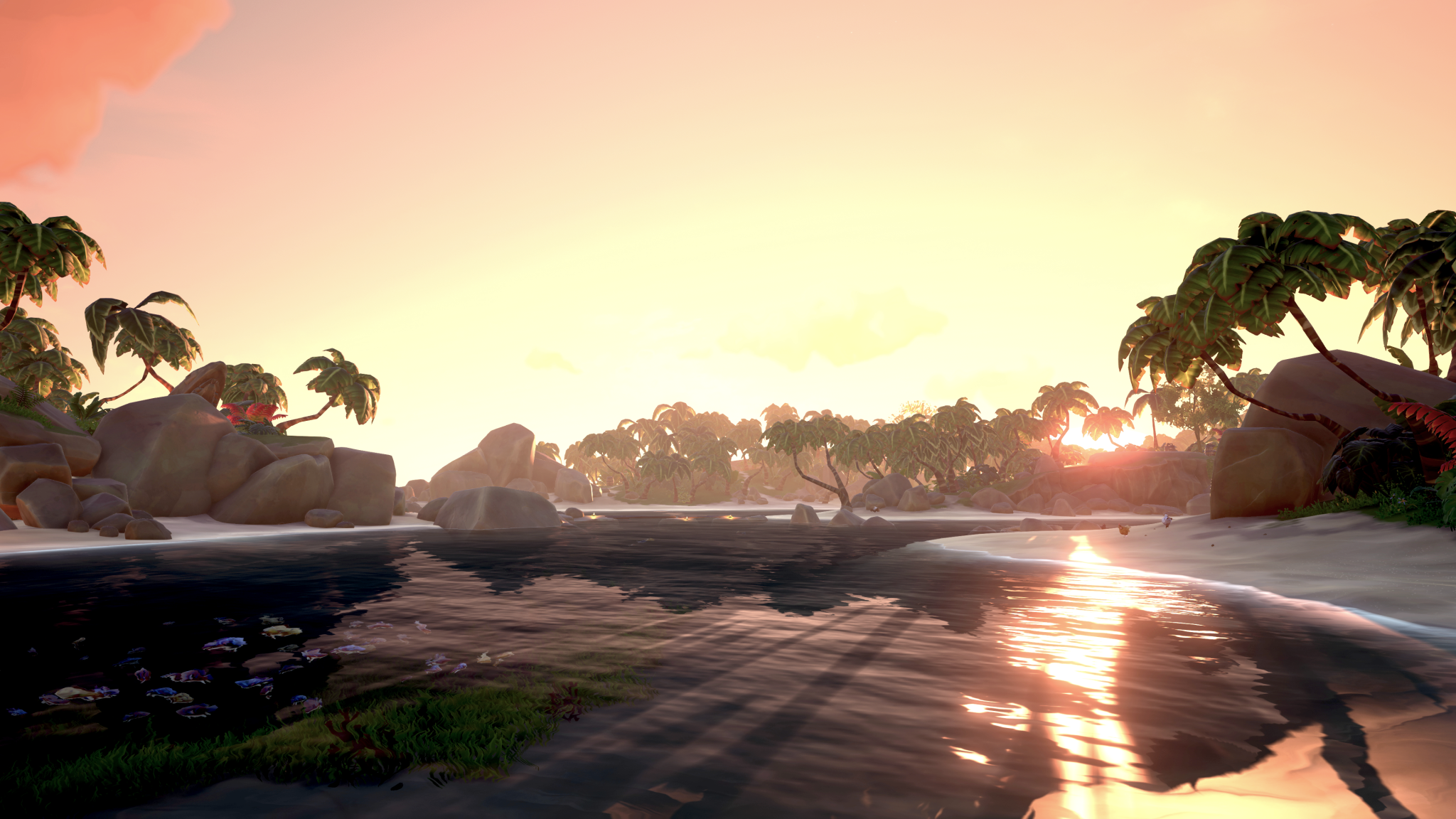

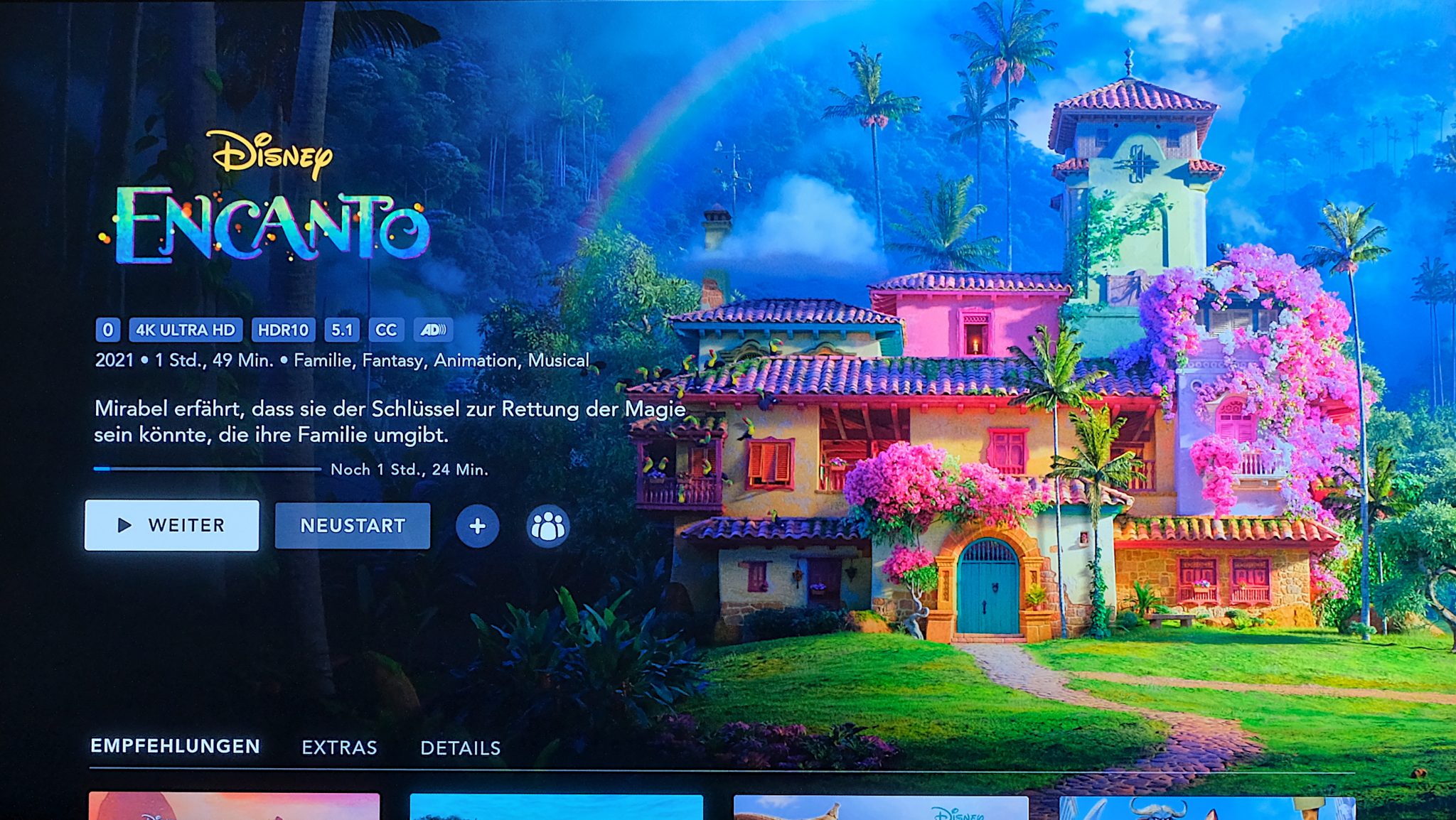

Ich habe versucht Bildschirme mit HDR und ohne HDR zu fotografieren, das Ergebnis war grauenhaft und nicht realitätsgetreu. Daher habe ich versucht mit den Spielebildern HDR zu simulieren. So ungefähr sieht es dann bei euch auf dem Monitor und Fernseher aus.

HDR-Aufnahmen sind besonders bei Fotos von Landschaften oder Innenräumen mit Lampen zu empfehlen. Aber eigentlich helfen sie bei jeder Art von Foto und moderne Geräte nehmen diese verschiedenen Belichtungen in Millisekunden auf. Es gibt also keinen Nachteil, den HDR-Modus bei Kameras nicht zu verwenden. In Videospielen und vielen Filmen, wird der HDR-Effekt künstlich hinzugefügt. Dort funktioniert er aber genauso.

Zusätzlich bedeutet HDR mindestens eine Farbtiefe von 10-Bit (1024 Farben für je Rot, Grün und Blau). Damit können deutlich mehr Farbtöne dargestellt werden, also bei „klassischen“ 8-Bit (256 Farben für je Rot, Grün und Blau). Daher wirken HDR-Aufnahmen farbstärker und können farblich deutlich genauer sein.

In diesem Artikel werdet ihr häufig die Bezeichnung „Nits“ beim Thema Helligkeit lesen. Die kurzzeitig erreichbare maximale Leuchtdichte des Panels, wird in Candela je Quadratmeter [cd/m²] gemessen. Alternativ wird sie auch „Nits“ genannt. Der Wert bezieht sich auf die Leuchtstärke einer Kerze.

Viele Fernseher auf LCD-Technik erreichen maximal 1.000 Nits, High-End-Fernseher von Samsung und Sony erreichen etwa 2.000 Nits. OLED-Fernseher bieten bessere Farben und dramatisch bessere Schwarzwerte, sind aber etwas dunkler als LCD-Fernseher. Der aktuelle Sony Bravia A90J OLED-Fernseher erreicht z.B. maximal 1.300 Nits. LG und Samsung arbeiten aber aktuell daran, diesen Nachteil auszugleichen.

HDR und seine unzähligen Varianten

Nun wissen wir, wie HDR grundsätzlich funktioniert. Über die Jahre haben viele Firmen damit experimentiert und ihre eigenen HDR-Varianten und offiziellen Standards erstellt. Die Standards sind gut vergleichbar mit HDR-Sprachen. Ein Film mit dem Dolby-Vision-Standard funktioniert nicht richtig auf einem Fernseher, der nur HDR10 beherrscht. Es ist also wichtig, das passende HDR-Medium für die HDR-Fähigkeiten des Monitors oder Fernsehers zu wählen.

Inzwischen gibt es unzählige Varianten, aber die wohl wichtigsten Standards sind HDR10, HDR10+, HLG und Dolby Vision. Daneben gibt es auch noch G-SYNC HDR von Nvidia, Freesync 2 HDR von AMD und verschiedene Versionen von DisplayHDR.

Besonders in der Anfangszeit von HDR wurde es gerne als Schlagwort für einige andere Techniken verwendet: So nennt Samsung die Umwandlung von SDR-Videos zu HDR-Videos HDR+ und bei LG heißt das HDR10 Pro. Diese verwirrenden Begriffe werden aber immer seltener und die offiziellen HDR-Standards setzen sich durch.

Der wohl am meisten verbreitete HDR-Standard ist HDR10. Es ist ein offener Standard und kann von jedem Hersteller kostenlos verwendet werden. So gut wie jedes aktuelle Gerät oder Streaming-Dienst beherrscht HDR10. Die wohl größte Einschränkung ist die Verwendung von statischen Metadaten. Die Helligkeit, der Kontrast oder die verwendeten Farben werden einmal für das ganze Medium festgelegt und verändern sich nicht mehr. Zusätzlich peilt HDR10 eine maximale Helligkeit von etwa 1.000 Nits an.

HDR10+ ist eine leicht verbesserte Version von HDR10. Es peilt eine maximale Helligkeit von 4.000 Nits an und bietet dynamische Metadaten. Das ist ein großer Schritt und bedeutet, dass – theoretisch – jeder Frame andere Werte für Helligkeit, Kontrast und Farbraum verwenden kann. In der Realität wechseln die Werte aber eher Szenenweise, wenn z.B. von einer Außenaufnahme in einen Innenraum oder von Tag zu Nacht gewechselt wird.

Leider ist HDR10+ kein offener Standard, sondern wird von einem Konglomerat aus großen Firmen (z.B. Samsung, Panasonic, TCL, Warner Brothers und 20th Century Fox) verwaltet. Die Nutzung kostet zwar keine Gebühr, aber manche Hersteller verzichten aufgrund von Konkurrenzkampf (LG und Samsung) auf diesen Standard. Die meisten Streaming-Dienste verwenden nur selten HDR10+.

HLG steht für „Hybrid Log–Gamma“ und wird hauptsächlich von der britischen BBC und NHK World Japan verwendet. Daher ist das Format weltweit nicht sonderlich verbreitet. Streaming-Dienste können einen Film in einer SDR-Variante und mehreren HDR-Varianten hochladen.

Bei der Fernsehausstrahlung funktioniert das nicht, dort wird nur ein Signal übertragen. Durch HLG wird gleichzeitig ein Signal als SDR- und HDR-Variante gesendet und ein Fernseher entscheidet nach seinen Fähigkeiten, welches der beiden Signale er nun verwendet. Neben den Fernsehsendern kommt das Format auch im BBC iPlayer und YouTube zum Einsatz.

Das Dolby Vision-Format kommt von den gleichen Entwicklern wie Dolby Atmos und Dolby Surround Sound. Es ist ein proprietäres Format mit dynamischen Metadaten, dessen Verwendung eine Gebühr kostet. Ein großer Vorteil des Formats sind seine 12-Bit-Farbtiefe (4096 Farben für je Rot, Grün und Blau) und einer maximalen Helligkeit von 10.000 Nits.

Da Dolby sein Marketing-Geld spielen lässt und es auch ein gewisses Prestige-Objekt ist, unterstützen viele Streaming-Dienste und aktuelle Konsolen das HDR-Format.

Für Computer-Monitore besonders wichtig ist DisplayHDR von VESA. VESA ist eine internationale Non-Profit-Organisation, die mehr als 3000 Firmen und Hersteller umspannt. VESAs DisplayHDR ist dabei kein eigener HDR-Standard, sondern ein Zertifizierungsprogramm. Diesen gibt es in verschiedenen Ausführungen und reicht von DisplayHDR 400 bis 1400.

Es gibt auch DisplayHDR TRUE BLACK von 400 bis 600. Wie der Name schon verrät, geht es hier um besonders gute Schwarzwerte und ist häufig bei OLED-Geräten zu finden. Die Zahl am Ende gibt die maximale Helligkeit in Nits an, die ein bestimmter Monitorbereich mindestens 30 Minuten halten muss. Jede VESA DisplayHDR-Zertifizierung gibt aber auch eine minimale dauerhafte Helligkeit an.

Als wichtiges Schlagwort gibt es noch HDCP (High-bandwidth Digital Content Protection). Das ist eine hardwareseitiger Kopierschutz für DVI, HDMI und DisplayPort. Damit sollen Raubkopien verhindert werden, die das Signal der Kabel abgreifen. Die Technik ist schon lange etabliert und der Standard 2.2 überall zu finden. Ihr müsst also nicht aktiv darauf achten, alle Geräte und Kabel kümmern sich im Hintergrund darum.

Es gibt natürlich weitere HDR-Varianten, wie etwa “Advanced HDR” von Technicolor, SL-HDR1 von Philips und Technicolor oder IMAX Enhanced, aber diese sind eher selten anzutreffen und decken eher bestimmte Nischen ab.

HDR-Formate und PC-Gaming

HDR am Gaming-Computer besteht aus zwei Themenbereichen: Einmal der Windows-Funktion für HDR und den HDR-Standards von AMD, Nvidia und bald Intel.

Während so gut wie jedes aktuelle Spiel HDR unterstützt, kämpft Windows leider seit Jahren mit der HDR-Funktion. HDR wird bei Windows nicht smart aktiviert, sondern ist entweder immer an oder aus. Gerade beim normalen Betrieb auf dem Desktop oder im Browser kann eine aktivierte HDR-Funktion die Farben oder den Kontrast ziemlich falsch darstellen.

Daher solltet ihr kurz bevor ihr ein HDR-Spiel startet, die Funktion aktivieren und danach wieder abschalten. Glaubt mir, damit spart ihr euch viele Nerven. Natürlich kann es sein, dass Microsoft die HDR-Fähigkeit ihres Betriebssystem in Zukunft verbessert und alles ordentlich funktioniert. Bisher ist es aber durchwachsen.

Die beiden großen Grafikkarten-Hersteller bieten ebenfalls HDR-Zertifizierungen an. Bei Nvidia heißt das „G-Sync Ultimate“ und AMD nennt es „Freesync 2 HDR“. Diese verdient sich ein Monitor, wenn er bestimmte Werte erreicht, die der Hersteller vorgibt. Meistens bewegen sich diese Werte irgendwo zwischen dem DisplayHDR 400 und 600. Ansonsten gibt es noch weitere Vorgaben, wie die Freesync-Funktion und „Low Framerate Compensation“ bei AMD.

BenQ und einige andere Hersteller bieten Monitore mit HDRi an. Das ist keine „echte“ HDR-Variante. Ein Algorithmus verarbeitet mithilfe eines Umgebungssensors ein SDR-Bild zu einem HDR-Bild. Der Vorteil soll sein, dass sich das HDR-Bild nach der Helligkeit der Umgebung und anderen Faktoren richtet. Damit soll es deutlich „smarter“ reagieren als normales HDR.

Da gerade Beleuchtungssystemen bei Videospielen in den letzten Jahren stark zugenommen haben, lohnt sich HDR für ein deutlich besseres Erlebnis. Die meisten Gaming-Monitore ab einem Preis von 250 Euro können aber inzwischen schon HDR. Es ist also nicht den High-End-Monitoren vorbehalten.

Technische Voraussetzung

Bitte lasst euch nicht von den technischen Voraussetzungen für HDR abschrecken. Sie klingen erstmal hoch, sind aber nicht schwer zu erreichen. Die reinen technischen Hürden sind: Das Wiedergabegerät (Fernseher, Monitor, Smartphone etc.), das Abspielgerät (Konsole, Blu-ray-Player, smarter Fernseher etc.) und das Medium (Videodatei, Streaming-Dienst, Videospiel etc.) müssen HDR in mindestens einem gemeinsamen Format beherrschen.

Das klingt jetzt erstmal nach vielen „Wenn“, aber im Grunde können alle aktuellen Geräte ab einem gewissen Preis HDR. Ein gewöhnlicher Gaming-Monitor kann HDR, die meisten aktuellen Spiele können HDR, alle Streaming-Dienste können HDR und alle aktuellen Konsolen können ebenfalls HDR. Wer also in den letzten fünf Jahren ein Medien-Gerät erworben hat, kann sehr wahrscheinlich HDR-Inhalte genießen.

Eine Kleinigkeit gibt es aber, auf die ihr achten solltet: Für die Übertragung von HDR-Inhalten braucht ihr mindestens einen HDMI 2.0a-Anschluss und das passende HDMI 2.0a/b-Kabel. Bei Gaming-PCs sollte es DisplayPort 1.4 sein. Der Standards HDMI 2.1 und DisplayPort 2.0 kann Inhalte mit HDR und mit einer Auflösung von bis zu 8K bewältigen.

Fazit: HDR macht alles besser

Solltet ihr aktuell auf der Suche nach einem neuen Monitor für euren PC oder einen Fernseher sein, achtet beim Kauf unbedingt auf HDR.

Die HDR-Technologie sorgt für ein deutlich besseres Bild und damit für ein besseres Erlebnis. Sei es nun beim Filme schauen oder Gaming, alles wirkt dadurch lebendiger und aufregender.

Hier eine kleine Auflistung, die ihr beim Kauf beachten solltet:

- Die meisten Gaming-Monitore und aktuellen Fernseher beherrschen HDR

- Bei Fernsehern sind die Angaben HDR10, HDR10+ und Dolby Vision wichtig

- Nicht alle Angaben auf der Box sind gleichermaßen wichtig (HDR10+)

- Bei Monitoren solltet ihr auf eine Angabe von VESA DisplayHDR achten.

- Je höher die Zahl hinter HDR, umso hübscher wird das Bild (z.B. HDR 600)

- Entweder können alle Teile eures Setups HDR oder ihr habt kein HDR

Wenn ihr die Punkte beachtet, sollte eurem HDR-Erlebnis nichts im Wege stehen. Es lohnt sich auf jeden Fall und wir wünschen euch viel Spaß dabei!

Zum Shop: HDR-Monitore

*Stand: 04.2022 – Videospielbilder stammen aus Destiny 2 von Bungie, Red Dead Redemption 2 von Rockstar, Sea of Thieves von Rare und Microsoft Studios, Assassin’s Creed Valhalla/Assassin’s Creed Odyssey von Ubisoft

![HM24 Gaming-PC HM247518 [AMD Ryzen 7 5700X / 32GB RAM / 1TB SSD / RTX 4070 / Win11 Pro]](https://media.nbb-cdn.de/product_images/listing_image/HM24-GamingPC-HM247518-p827544?size=195)